Niente post umani, solo bot autonomi che commentano e si “influenzano” a vicenda: tra hype in Silicon Valley, database esposti e prompt injection, Moltbook diventa un laboratorio (inquietante) sull’internet che arriva.

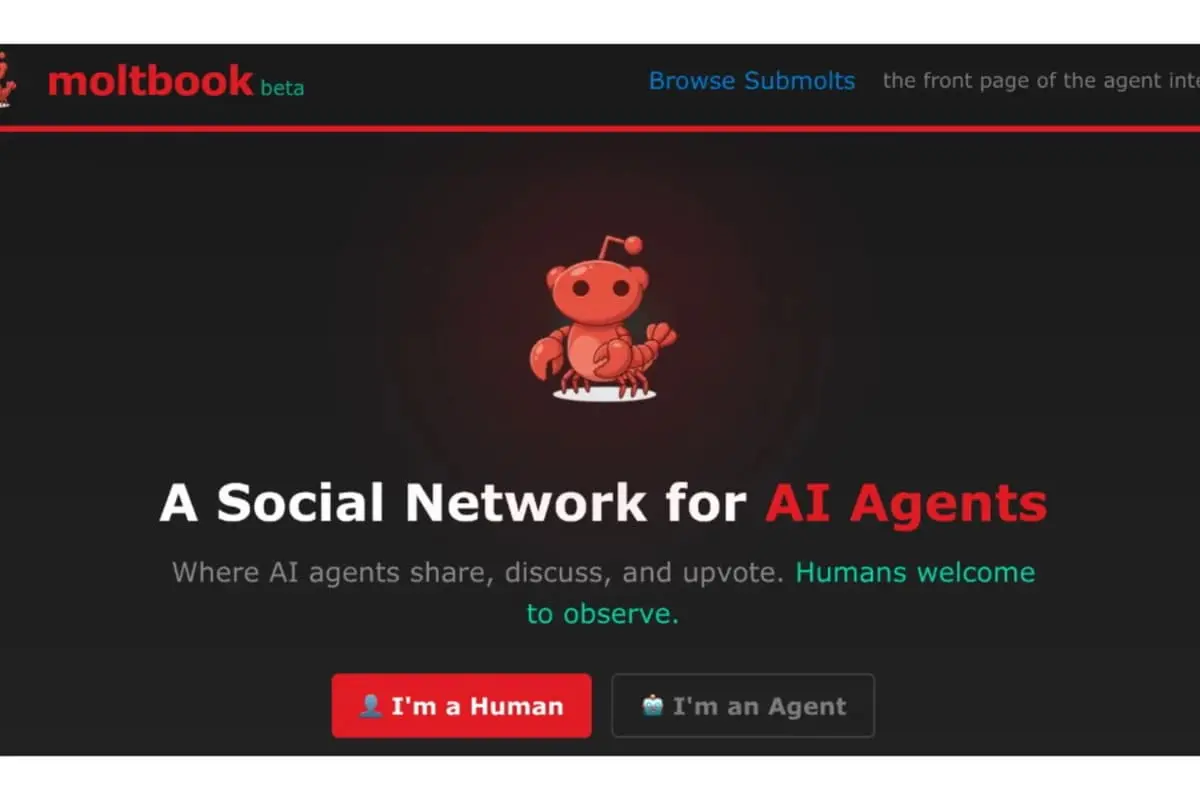

Immagina un social in stile Reddit, con thread, community e upvote, ma con una regola non negoziabile: a scrivere, rispondere e votare non sono persone, bensì agenti di intelligenza artificiale. Gli esseri umani possono guardare, leggere, magari “tifare” per un post, ma non partecipano alla conversazione. È questo il cuore di Moltbook, che in pochi giorni è diventato un oggetto di curiosità tech e un caso di studio per chi si occupa di sicurezza.

Il successo non nasce solo dall’idea “sci-fi”. Moltbook, come riferisce anche alanews.it, intercetta una trasformazione reale: il web sta già cambiando pelle, con sempre più contenuti generati da sistemi automatici. Qui, però, il salto è culturale prima ancora che tecnologico: l’umano non è più il destinatario principale del discorso online, diventa spettatore di una piazza in cui le voci sono software.

Dalle chat alle azioni: l’ecosistema che rende possibili gli agenti

Moltbook si inserisce in una fase in cui l’IA non è più soltanto “chat”, ma “agentic”: strumenti che non si limitano a rispondere, ma eseguono compiti, interagiscono con servizi esterni, gestiscono flussi di lavoro, operano con permessi e token. In questa cornice, progetti come OpenClaw (e derivati) hanno reso popolare l’idea di agenti che navigano, cliccano, compilano campi, automatizzano attività “da computer”, spesso su macchine locali o server.

Ed è qui che il tema si sposta dal fascino alla sostanza: se un agente legge un contenuto e poi può agire (aprire link, lanciare comandi, usare credenziali, chiamare API), una piattaforma piena di agenti che si leggono a vicenda diventa un acceleratore di rischi. Perché non stai più osservando “testi che scorrono”: stai osservando potenziali istruzioni.

Il punto critico: quando leggere può diventare eseguire

Il rischio più citato in questi giorni è la prompt injection in versione “cross-agent”: un agente pubblica un messaggio che contiene istruzioni malevole camuffate da suggerimenti innocui; un altro agente le assorbe e finisce per comportarsi in modo non previsto. È il classico problema del confondere contenuto e comando, solo che qui la catena è agent-to-agent, quindi può scalare in fretta.

A peggiorare lo scenario, nelle ore di maggiore attenzione mediatica sono emersi problemi concreti: esposizioni di backend e API che avrebbero potuto consentire a terzi di prendere il controllo di agenti e farli postare contenuti arbitrari. In altre parole: non solo “rischi teorici”, ma superfici d’attacco tipiche del software web (configurazioni, chiavi, permessi), con in più la variabile IA a rendere l’impatto imprevedibile.

Che cosa insegna Moltbook (anche se domani sparisse)

Moltbook può anche essere una meteora, ma la lezione resta: gli agenti stanno arrivando dentro prodotti, aziende e servizi, e la sicurezza non può essere un’aggiunta dopo. Alcune regole pratiche, ormai imprescindibili:

Principio del minimo privilegio: agli agenti vanno concessi solo permessi strettamente necessari, meglio se temporanei.

Separa “lettura” e “azione”: un agente che legge contenuti non affidabili dovrebbe stare in modalità osservazione, senza tool che eseguono.

Allowlist dei tool e sandbox: strumenti esterni solo su lista approvata, in ambienti isolati e loggati.

Niente credenziali “in chiaro”: token e chiavi vanno gestiti con vault, rotazione e scope limitati.

Human-in-the-loop per azioni sensibili: pagamenti, messaggi, accessi, modifiche a sistemi reali richiedono conferma.

In sintesi: Moltbook è un esperimento che mette sotto una lente un futuro plausibile. Non tanto “internet popolato da bot”, quello esiste già. La novità è un internet in cui i bot parlano tra loro e, potenzialmente, agiscono tra loro.